Штучний інтелект все більше використовується в нашому житті. Платформа MSTY LLM, яку ми розглянемо далі, обрана через її потужні можливості. Вона забезпечує високу точність та гнучкість, що робить її ідеальною для різних завдань, від автоматизації рутинних процесів до створення творчого контенту.

Крім того, MSTY LLM має хорошу репутацію серед користувачів завдяки своїй здатності швидко адаптуватися до нових задач та забезпечувати гарні результати. Це робить її відмінним вибором для тих, хто шукає надійний інструмент для роботи з текстом та даними.

У цій статті я розповім звідки завантажити MSTY LLM, як встановити та налаштувати на комп'ютері з Windows 11. Також дізнаємося, чи безпечна це платформа, та загалом ШІ-помічники, в повсякденному використанні.

Що таке MSTY LLM?

MSTY LLM (Multi-Scenario Text Yielder Language Model) – це передова платформа на основі штучного інтелекту, призначена для генерації тексту, що імітує людське спілкування на основі введених користувачем запитів чи підказок. Вона може використовуватися для створення контенту, надання підтримки клієнтам та освітніх цілях.

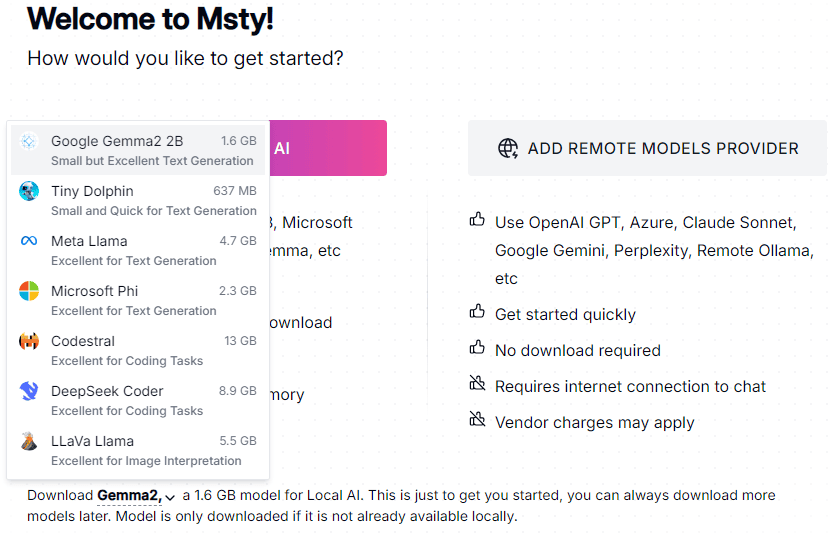

Ви можете використовувати різні моделі на свій розсуд:

- Google Gemma – легка, сучасна відкрита модель, розроблена для завдань обробки природної мови. Ця модель створена на основі Gemini.

- Tiny Dolphin – експериментальна модель штучного інтелекту, розроблена на основі моделі TinyLlama та навчена на новому наборі даних Dolphin 2.8. Ця модель має 1.1 мільярд параметрів та призначена для завдань генерації тексту.

- Meta Llama – велика мовна модель розроблена компанією Meta. Ця модель призначена для генерації тексту та може виконувати різноманітні завдання обробки природної мови.

- Microsoft Phi – мала мовна модель розроблена компанією Microsoft. Модель оптимізована для високої продуктивності при низьких витратах і низькій затримці, що робить її ідеальною для різноманітних завдань генеративного штучного інтелекту.

- Codestral – генеративна модель штучного інтелекту, розроблена компанією Mistral AI, спеціально для завдань генерації коду. Модель може працювати з понад 80 мовами програмування, включаючи популярні, такі як Python, Java, C++, jаvascript, Bash, а також специфічні, як Swift та Fortran.

- DeepSeek Coder – модель штучного інтелекту, розроблена для генерації коду. Ця модель створена компанією DeepSeek AI та підтримує більше ніж 80 мов програмування.

- LLaVa Llama – мультимодальна модель, розроблена для обробки як тексту, так і зображень. Вона створена на основі моделей LLaMA та Vicuna і має можливості, подібні до GPT-4.

Msty пропонує простий та зручний інтерфейс для роботи з локальними та онлайн-моделями штучного інтелекту. Ви можете завантажувати та запускати моделі локально на своєму комп'ютері без підключення до інтернету, гарантуючи, що ваші дані залишаються приватними та безпечними.

Чи безпечна вона для Windows?

Користувачі повинні дотримуватися заходів безпеки при використанні цієї платформи. Навіть, якщо не налаштовані скептично, не слід ділитися будь-якою особистою інформацією.

Для підтримки безпеки MSTY LLM розробники стверджують що:

- Не зберігають ваші персональні дані які передаються під час сеансу, тому, як тільки ви відключаєте сеанс, всі ваші дані втрачаються.

- Постійно аналізують вміст платформи та відфільтровують все, що здається недоречним чи шкідливим.

- Постійно слідкують за станом платформи та надсилають оновлення для вирішення будь-яких проблем.

MSTY LLM забезпечує безпечну роботу завдяки практикам конфіденційності даних, модерації контенту та оновлень. Та, навіть незважаючи на це, потрібно і самим бути обережними під час використання технологій штучного інтелекту.

Завантаження та встановлення MSTY LLM на ПК

Для запуску MSTY LLM знадобиться Windows 10 або 11, Mac чи Linux. Також потрібно буде щонайменше 8 Гб оперативної пам'яті (рекомендується мати 16 Гб), сучасний багатоядерний процесор та, бажано, дискретна відеокарта, хоча це не обов’язково та досить буде інтегрованого відео.

Встановити MSTY LLM на ваш комп'ютер дуже просто. На офіційному сайті є інсталяційний носій для встановлення утиліти. Пройдемо цей шлях по крокам.

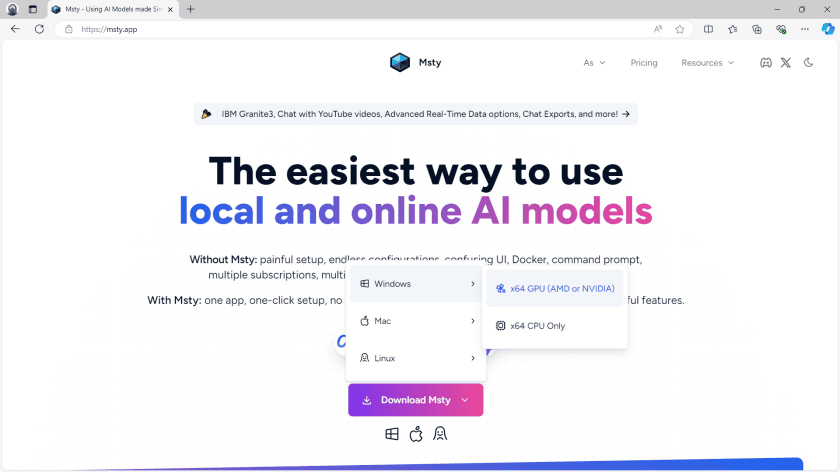

- Перейдіть до msty.app

- Натисніть «Download Msty» та виберіть необхідну платформу. Зверніть увагу що для завантаження доступні версії з задіянням відеокарти або з використанням виключно процесора.

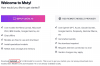

- Після завантаження інсталяційного носія запустіть його, щоб встановити платформу на комп'ютер. Інсталятор не задає зайвих питань та зразу відкриває вікно налаштування.

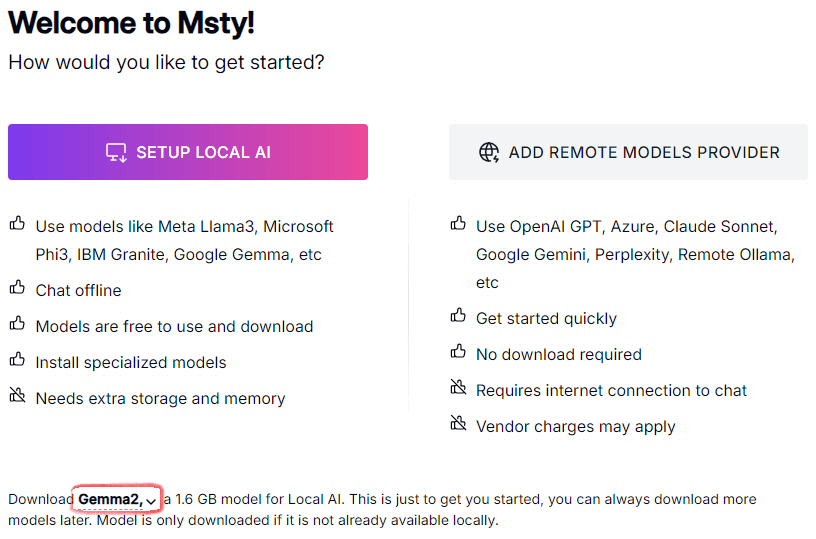

- Виберіть мовну модель для завантаження та встановлення на платформі Msty. Поряд з назвою вказано розмір пакету, від 600 Мб до 13 Гб. Я обрав Google Gemma. Надалі можна буде додавати нові та видаляти зайві мовні моделі.

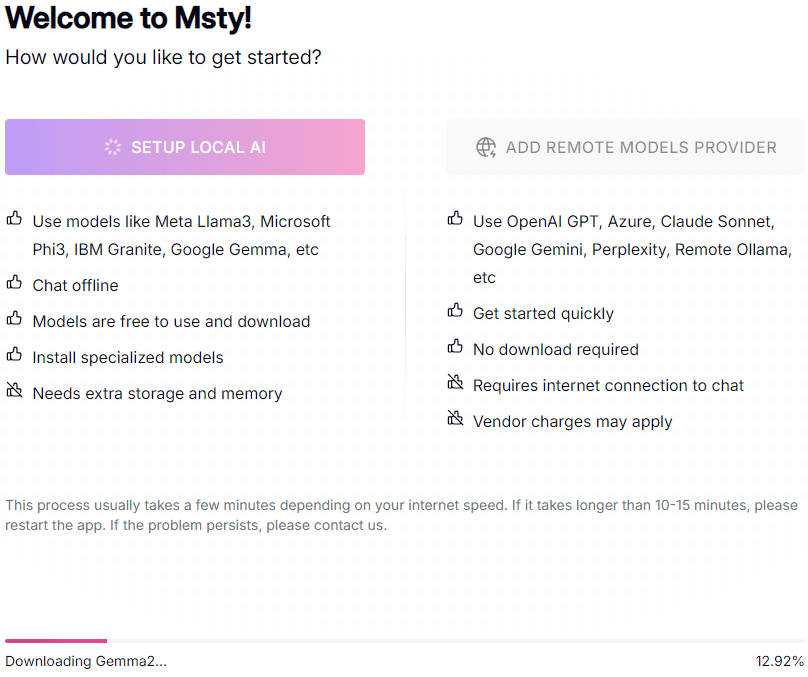

- Натисніть «Setup local AI» щоб налаштувати локальний ШІ. Також можна додати віддалену онлайн модель натиснувши «Add remote models provider». Почекайте поки інсталятор завантажить та встановить модель LLM необхідну для використання ШІ.

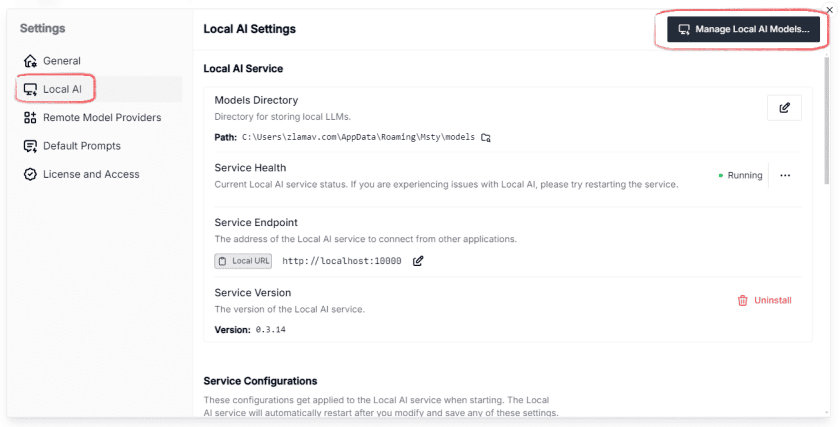

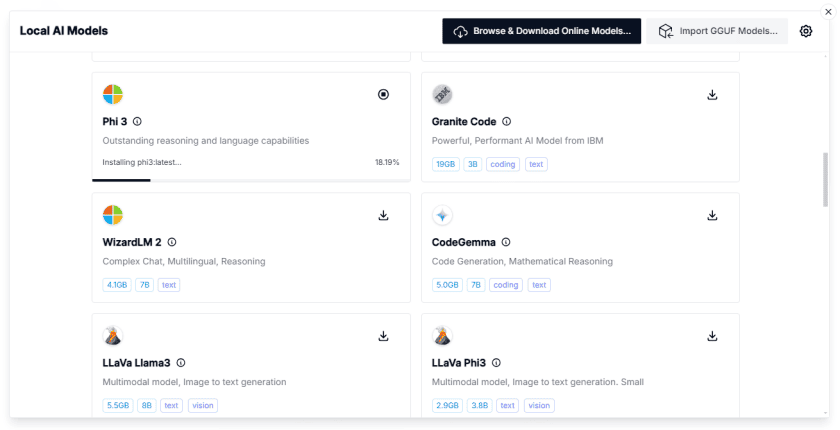

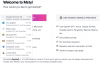

- Далі, для прикладу, пропоную встановити ще одну мовну модель. Перейдіть у налаштування (кнопка у вигляді шестерні, зліва внизу на головному екрані). Потім у пункті меню «Local AI», натисніть на кнопку «Manage Local AI Models», виберіть модель та натисніть кнопку для завантаження. Обрана мовна модель автоматично налаштується та підключиться до платформи Msty.

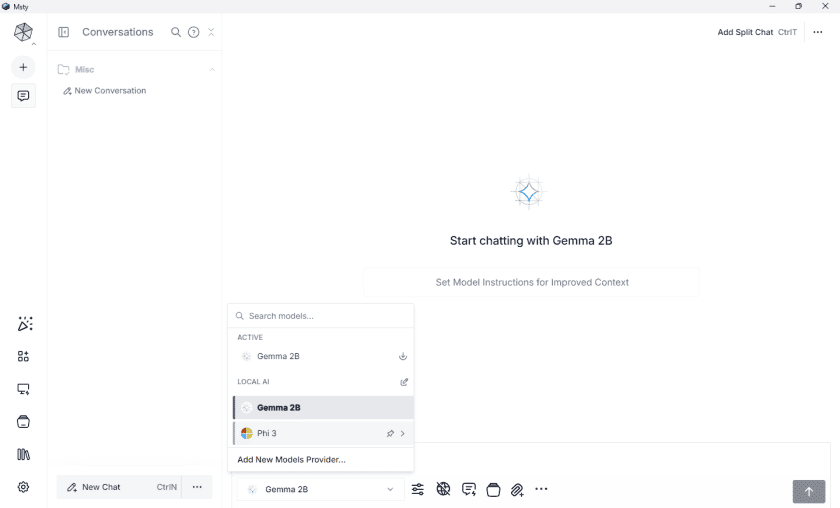

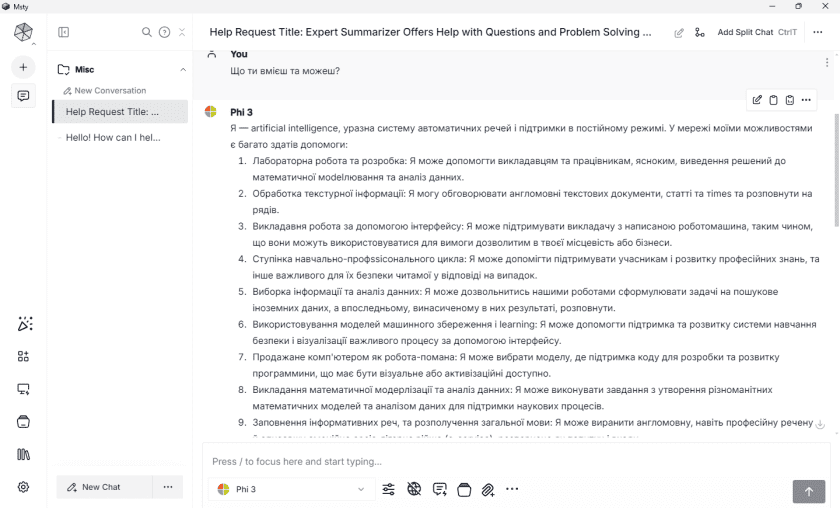

- Після цього в списку доступних для роботи мовних моделей окрім Gemma 2B з’явиться ще й Phi 3.

Таким способом можна додати декілька моделей та, в залежності від поставлених цілей, поперемінно користуватися найбільш зручнішою та доцільнішою.

Висновок

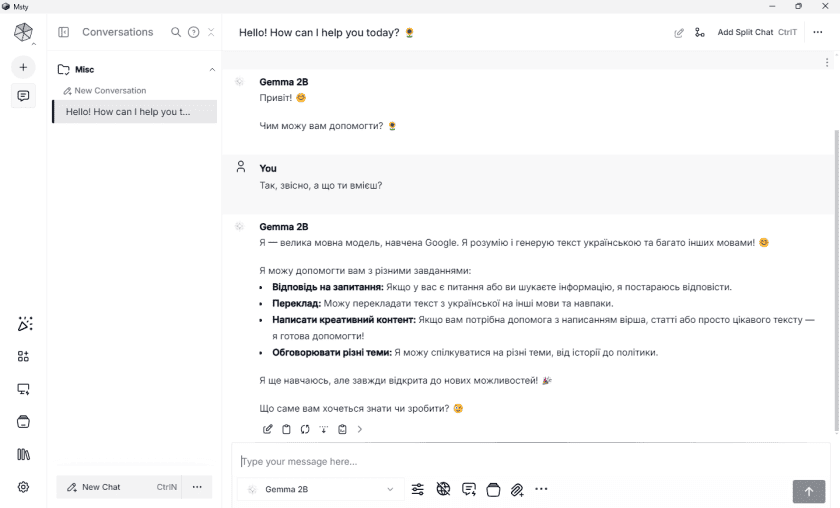

Дуже доречним виявилась наявність локального варіанта роботи платформи без використання інтернету. Перше повідомлення будь-якої моделі генерується дещо довго, але потім все налагоджується та працює швидко. Також, багато мовних моделей з яких є що вибрати. Проте кожну з них потрібно тестувати та дивитися як вона покаже себе в потрібних сценаріях роботи. В моєму, ознайомчому, випадку Gemma 2B проявила себе досить добре, а он Phi 3 видавала щось не зовсім адекватне.

Результат також залежить і від теми спілкування. Більш технічні завдання по системі Windows, утилітах чи ШІ виходять дуже низької якості. Іноді здається, що модель зовсім не розуміється на темі та генерує просто щось, де зустрічаються слова з мого запиту без смислу.